Nvidia lance la plateforme Rubin. La puce Rubin succède à Blackwell et alimentera de nouveaux systèmes d’IA puissants à partir du second semestre de cette année, en collaboration avec le processeur Vera.

Lors du CES, Nvidia lance comme prévu la puce Rubin. Rubin succède à Blackwell et devrait être cinq fois plus performant que son prédécesseur en matière d’inférence. Rubin contient 336 milliards de transistors, soit 50 pétaflops de puissance de calcul NVFP4. La vitesse de traitement pour l’entraînement des modèles d’IA est légèrement inférieure, avec 35 pétaflops, soit environ 2,5 fois plus que Blackwell.

Approche par plate-forme

La nouvelle puce fait partie de ce que Nvidia appelle la plateforme Rubin. Cette plateforme comprend également le nouveau processeur Vera basé sur ARM. Il comprend 88 cœurs Olympus, développés par Nvidia lui-même et compatibles avec Armv9.2. La puce s’appuie sur NVLink-C2C comme interconnexion. Le nom des deux puces provient de Vera Florence Cooper Rubin : une astronome américaine.

Nvidia combine l’accélérateur Rubin et le processeur Vera en Vera Rubin : un tandem qui succède à Grace Hopper. Vera Rubin NVL72 est un rack serveur complet dans lequel le matériel est combiné en un système AI-HPC. Les composants du rack communiquent entre eux via la sixième génération de NVLink. Le ConnectX9-SuperNIC, un accélérateur réseau, fait également partie de la conception, ainsi que le BlueField-4-DPU.

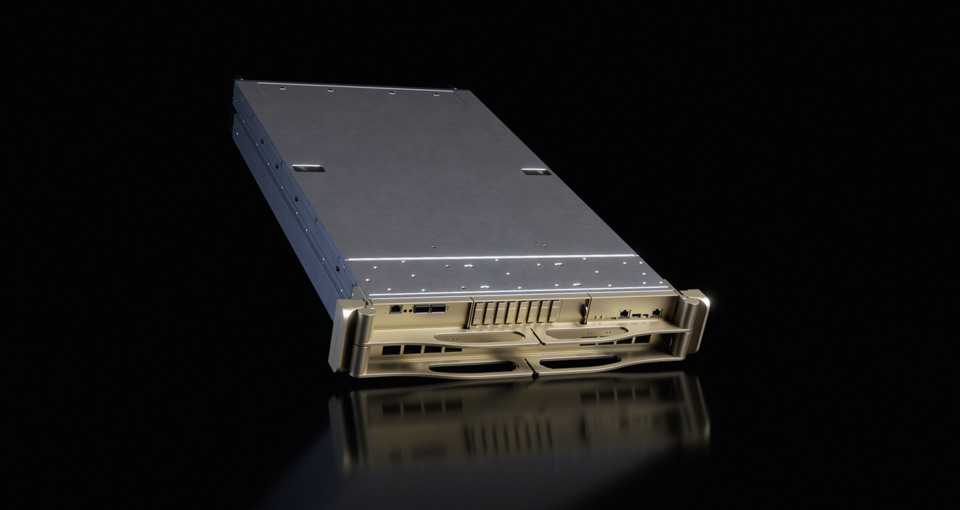

Nvidia emballe également Rubin dans un système plus petit : DGX Rubin NVL8. Il s’agit d’un serveur plus classique avec huit GPU Nvidia Rubin à bord, combinés à un processeur Intel Xeon 6776P à double socket. Le x86-gebaseerde

SuperPOD

Enfin, Nvidia fournit l’architecture pour déployer et combiner Vera Rubin NVL72 ou DGX Rubin NVL8 à grande échelle en clusters. Cela se fait via Nvidia DGX SuperPODs. Un seul Nvidia DGX SuperPOD peut comprendre huit racks Nvidia DGX Vera Rubin NVL72, ou 64 serveurs DGX Rubin NVL8.

Avec Rubin, Nvidia se concentre à nouveau sur les grands producteurs d’IA de ce monde. Entre autres, OpenAI, Microsoft, AWS et Google attendent le matériel puissant, tout comme Meta et Oracle. Les fabricants tels que HPE, Dell et Lenovo veulent également adopter Rubin.

lire aussi

Qui va refroidir et alimenter les racks de serveurs IA de 1 MW (et comment) ?

Nvidia revendique une plus grande efficacité avec les nouveaux composants. Le prix par jeton d’inférence diminuerait d’un facteur dix par rapport à la génération précédente. Dans le même temps, Rubin permet une densité plus élevée des systèmes. Les clusters refroidis à l’eau avec des puissances par rack de 200 watts entrent en ligne de mire avec ce matériel. La soif de plus de puissance de calcul de l’IA et, par conséquent, de plus d’électricité, ne diminuera pas avec l’introduction de Rubin.

Les puces Rubin seraient actuellement produites en volume. Les premières solutions avec Rubin à bord devraient être disponibles via des partenaires au cours du second semestre 2026. Tous les grands fournisseurs de cloud prévoient de mettre des instances Vera Rubin au menu cette année.