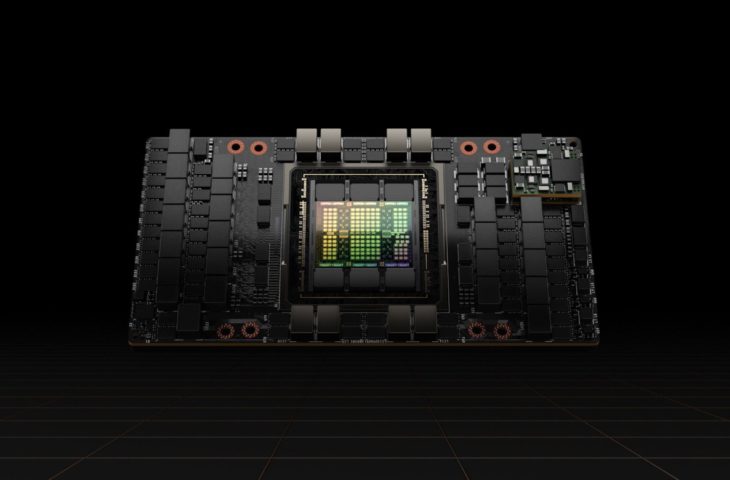

Pendant l’entraînement du Llama 3, les GPU Nvidia H100 se sont avérés les composants les plus fragiles. Plus précisément, c’était plutôt la mémoire HBM3 qui a le plus souvent échoué.

Meta a entraîné Llama 3 405B sur un supercalculateur équipé de 16 384 GPU Nvidia H100 de 80 Go. Pendant la période d’entraînement de 54 jours, 419 composants du cluster sont tombés en panne. Donc en moyenne, toutes les trois heures environ, un problème est survenu.

Composant fragile

Pour environ la moitié des cas, le problème était « lié » aux GPU H100. Dans 17,2 % des cas, le problème provenait d’une défaillance de la mémoire HBM3. Dans 30 % des cas, un autre problème lié au GPU (ou NVLink) était à l’origine de la panne.

Seuls deux processeurs ont planté pendant l’entraînement. Les autres défaillances sont dues à une multitude de bogues matériels et logiciels. Ainsi, les GPU se sont révélés être les composants les plus fragiles du cluster, bien que l’impact des défaillances ait été limité au cours de la période d’entraînement. Selon Meta, il a été possible de s’entraîner efficacement 90 % du temps.

L’entreprise a utilisé diverses techniques pour atténuer les défaillances des composants. En effet, étant donné l’ampleur du cluster d’entraînement, les erreurs étaient inévitables. Pour que la formation soit efficace, un grand système parallèle doit savoir gérer les problèmes locaux. Meta a utilisé un logiciel pour détecter rapidement les GPU défaillants et résoudre rapidement les problèmes. Cette tâche a été principalement réalisée de manière automatique. Il a fallu une intervention manuelle pour résoudre trois incidents seulement.

Désavantage d’échelle

Ces chiffres illustrent les difficultés liées à la formation de grands modèles d’intelligence artificielle. La taille des clusters d’apprentissage est tellement importante que les problèmes fréquents font partie du processus d’apprentissage. Les chercheurs et les spécialistes doivent veiller à ce que la formation se poursuive même en cas de défaillance du matériel.

Meta a été confronté à un problème toutes les trois heures en moyenne, mais le développement de clusters d’IA beaucoup plus importants est déjà en hausse. L’entreprise xAI d’Elon Musk veut construire un cluster de 100 000 GPU Nvidia H100. Si ses composants tombent en panne à la même échelle, les ingénieurs de xAI devraient veiller à ce que les perturbations soient résolues sans heurts plusieurs fois par heure.