Le fournisseur de cloud AWS souhaite vous aider à développer et à intégrer des applications d’IA générative. À cette fin, l’entreprise lance plusieurs solutions destinées à la fois à la formation et à l’inférence.

AWS refuse de rester à l’écart. Au cours des dernières semaines et des derniers mois, Microsoft et, dans une moindre mesure, Google, en particulier, ont lancé plusieurs projets d’IA consécutifs. Microsoft bénéficie également d’un accès préférentiel aux modèles GPT de cette société grâce à sa participation d’un milliard de dollars dans OpenAI. L’interconnexion entre ses modèles d’IA générative et Azure est assurément un atout pour le fabricant. AWS a donc tout intérêt à réagir.

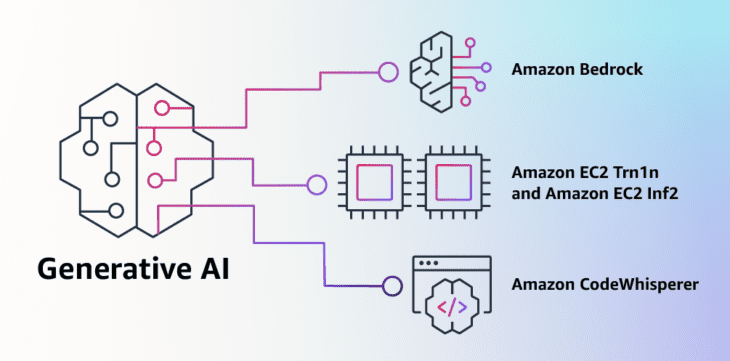

Cela se traduit par quatre services différents. AWS veut vous aider à former des modèles et à effectuer des inférences. OpenAI, et donc le modèle GPT-4, brille en absence, mais Amazon propose quelques solutions de rechange.

Bedrock

Tout d’abord, AWS présente Amazon Bedrock. Cette solution vous permet de développer vos propres applications d’IA à grande échelle sur la base des modèles d’AI21Labs, d’Anthropic, de Stability AI et d’Amazon Titan. Bedrock permet aux clients de former des modèles de la liste à partir de leurs propres données. Cela se fait sur la base d’API.

Les modèles disponibles sont adaptés à la génération de textes et d’images. Sous la marque Amazon Titan, AWS lance elle-même deux nouveaux grands modèles de langage (« Large language model »). AI21Labs présente les modèles Jurassic-2. Ces modèles sont adaptés au texte et peuvent traiter spécifiquement les langues européennes telles que l’espagnol, le français, l’allemand, le portugais et le néerlandais.

Grâce à Bedrock, les utilisateurs peuvent modifier rapidement les modèles à leur guise. On peut citer quelques exemples pour personnaliser le modèle en fonction des besoins de votre entreprise. AWS cite l’exemple d’un détaillant de mode qui donne à un modèle l’accès aux slogans des campagnes de marketing les plus réussies pour les sacs à main au cours des dernières années. À partir de ces informations, le modèle peut générer une nouvelle campagne qui respecte les facteurs de réussite.

Instances

Ensuite, AWS introduit de nouvelles instances pour la formation et l’inférence de l’IA générative. Pour l’inférence, il s’agit d’instances Amazon EC2 Inf2, construites autour des puces Inferentia2. Elles sont optimisées pour l’IA générative et devraient avoir un débit quatre fois plus élevé et une latence dix fois plus faible que leurs prédécesseurs. AWS revendique une amélioration de 40 % du rapport prix-performance.

Les instances Trn1n, quant à elles, sont destinées à la formation. Ces instances sont également équipées d’accélérateurs de leur propre fabrication : les puces Trainium. Les utilisateurs peuvent combiner des instances dans ce que l’on appelle des UltraClusters, avec jusqu’à 30 000 puces Trainium à bord. Cette configuration permet d’obtenir plus de six exaflops de puissance de calcul pour l’IA.

Concurrent du copilote

Enfin, AWS lance Amazon CodeWhisperer. Ce concurrent de GitHub Copilot est capable, comme celui de Microsoft, d’aider les programmeurs en leur suggérant du code. CodeWhisperer utilise également l’IA générative, bien sûr, et peut déjà gérer Python, Java, JavaScript, TypeScript et C# aujourd’hui.

CodeWhisperer a déjà été lancé l’année dernière, mais il est désormais disponible de manière générale. Avec ce lancement plus généralisé, AWS assure aussi la compatibilité avec dix nouveaux langages, dont Kotlin, Rust, PHP et SQL.

Annonces importantes

La série d’annonces d’AWS couvre un champ très large et montre que le fournisseur de cloud a une peur bleue de louper la course de l’IA. AWS dispose de nombreuses capacités internes uniques, notamment la possibilité de personnaliser ses propres puces d’accélération puissantes. Les instances de formation et d’inférence en font bon usage. De plus, ces annonces arrivent juste à temps, car AWS a récemment annoncé un programme d’accélérateur d’IA.

Bedrock semble également avoir une grande valeur. L’approche API et la possibilité de modifier les modèles à votre guise à l’aide d’un ensemble limité d’exemples sont attrayantes. C’est assez évidente que cette valeur ajoutée existe.

Par ailleurs, AWS a bien raison de rappeler qu’OpenAI, avec ses modèles GPT, n’est pas la seule à disposer d’un LLM puissant pouvant fonder l’IA générative. En ce sens, l’offre diversifiée apporte une valeur ajoutée, même si le sentiment que l’offre serait plus complète avec un partenariat avec OpenAI demeure. ChatGPT est simplement le produit phare du moment. Son étroite collaboration avec Microsoft et Azure donne à ce grand concurrent un peu plus d’autorité et de crédibilité en matière de formation et d’inférence de l’IA dans le cloud.