Jensen Huang, le PDG de Nvidia, veut qu’on construise davantage de centres de données dans des lieux non utilisés aujourd’hui, afin de former des modèles d’IA.

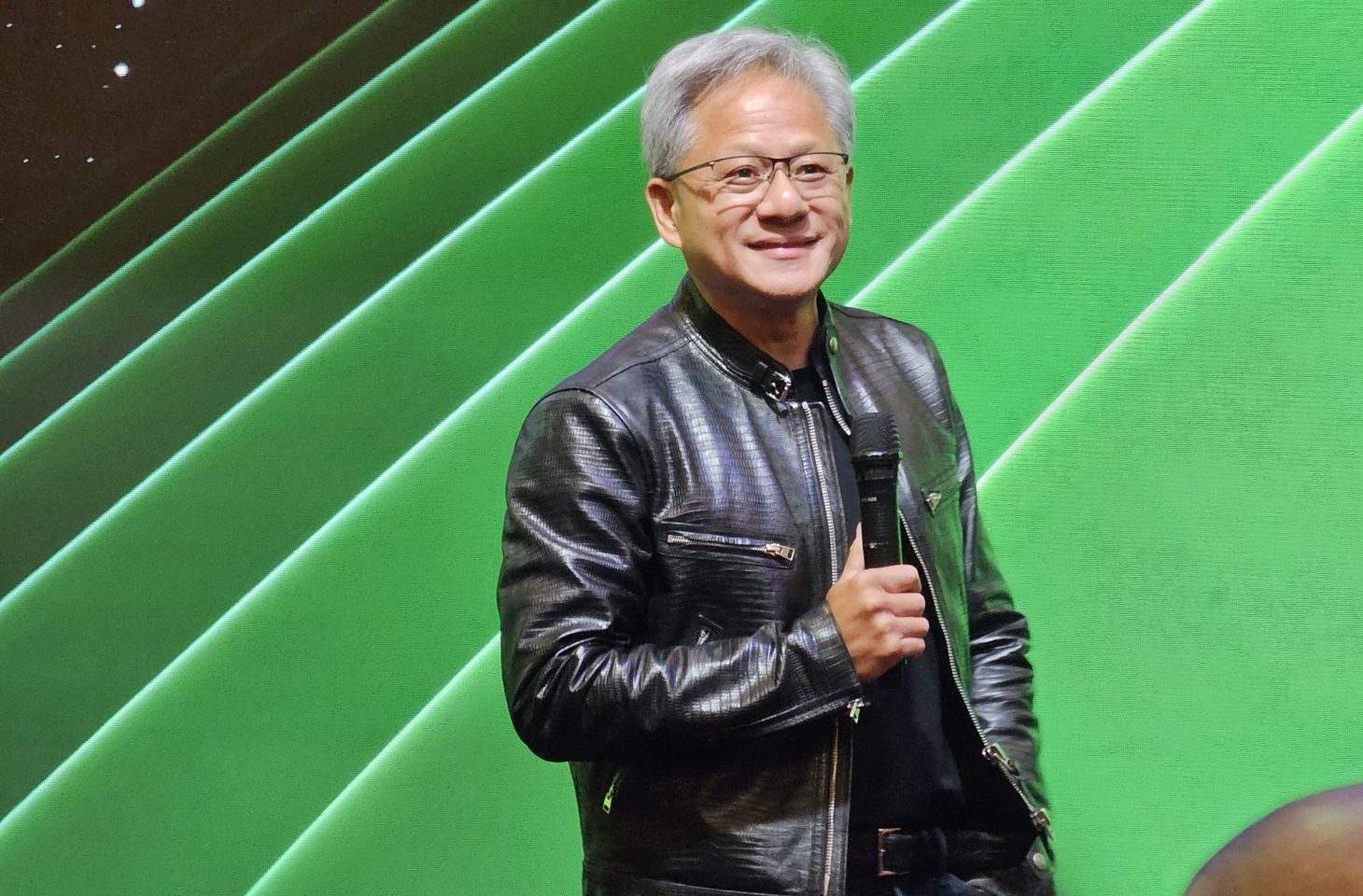

Lors du Computex, on entend Nvidia vraiment partout, son PDG, Jensen Huang, est reçu comme une rock star. Pendant une série de questions, l’un des journalistes lui lance même un « nous vous aimons », et il en rit.

Quand ils posent une question sur la durabilité, Huang veut expliquer clairement son point de vue. Il sait très bien que ses nouvelles puces requièrent de plus en plus d’énergie. La dernière puce Blackwell B200 nécessite pas moins de 1 200 watts d’énergie. Pourtant, il donne une réponse explicite.

« L’IA se moque d’où elle va à l’école. Le monde ne dispose pas de suffisamment d’énergie à proximité de la population. »

Il mentionne à cet égard les surplus d’énergie qui se réduisent de plus en plus dans des grandes villes comme Amsterdam ou Taipei, où les nouvelles entreprises ne peuvent plus être connectées au réseau électrique.

En même temps, le monde dispose de beaucoup d’énergie en surplus. Le soleil peut fournir énormément d’énergie. Seul inconvénient : la production se fait dans des endroits où personne ne vit. Il faut donc construire des centres de données et des centrales électriques pour former l’IA dans ces endroits.

Travailler plus vite

La formation d’un modèle d’IA via l’apprentissage profond est la plus gourmande en énergie. Pendant cette formation, la connectivité externe n’est guère nécessaire et la latence n’a pas d’importance. Une fois que les données sont disponibles, la formation peut commencer. Ce processus est répété en continu jusqu’à ce que le modèle soit suffisamment intelligent.

Le résultat final est un LLM (« Large Language Model ») tel que GPT-4, LLaMA 2, Claude ou Gemini.

Aujourd’hui, cette formation est accélérée par les GPU, ce qui est beaucoup plus économe en énergie qu’un CPU classique. Un GPU peut fonctionner de manière accélérée jusqu’à 99 % plus efficacement qu’un CPU. Cela constitue en soi une énorme économie en termes de coûts énergétiques. C’est pourquoi il existe aujourd’hui des outils tels que ChatGPT. Un CPU ne peut pas former ces modèles de manière suffisamment rapide et efficace.

Il faut améliorer l’inférence

Outre l’implantation de nouveaux centres de données spécifiquement destinés à la formation de modèles d’IA, le PDG de Nvidia voit une grande marge de progression au niveau de l’inférence. C’est le niveau où le modèle est utilisé dans la pratique, une fois la formation terminée. Par exemple, chaque question qu’on pose à ChatGPT nécessite de l’inférence.

« L’IA générative n’est pas une question de formation, mais d’inférence. Il y a beaucoup de choses qui ne sont pas suffisamment optimisées aujourd’hui. Considérez par exemple l’outil que nous avons développé pour les simulations météorologiques à Taïwan. Il fonctionne avec notre matériel du côté de l’inférence 3 000 fois plus efficacement qu’auparavant. Le mot clé est l’accélération de la puissance de calcul. »

« Oubliez la formation et pensez plutôt à l’inférence. C’est là que l’on peut enregistrer des gains d’énergie majeurs, ce qui rend le tout plus durable. »

Le fait que cette puissance de calcul supplémentaire permette une plus grande accélération, et donc repousse à nouveau les limites, entraînant une plus grande consommation d’énergie… Il ne dit rien à ce sujet.