Après des années de bla-bla, c’est l’heure de boum-boum : la super-puce Grace Hopper de Nvidia est enfin produite en grande quantité. Cette puce est un élément clé de la stratégie de Nvidia pour l’avenir.

Au printemps 2021, Nvidia a lancé la puce Grace lors de la conférence GPU Technology : un processeur ARM conçu pour les centres de données. Peu après, on a constaté que la puce Grace n’était pas destinée à fonctionner de manière autonome. La mission principale de Grace est de coexister avec un GPU Nvidia sur une seule « super-puce ». Grâce à une connexion rapide entre le GPU et le CPU et à une mémoire partagée, une telle puce devrait être parfaitement adaptée aux charges de travail de l’IA. Cela fait plus d’un an que Nvidia parle de cette super-puce Grace Hopper avec beaucoup d’enthousiasme.

Caractéristiques

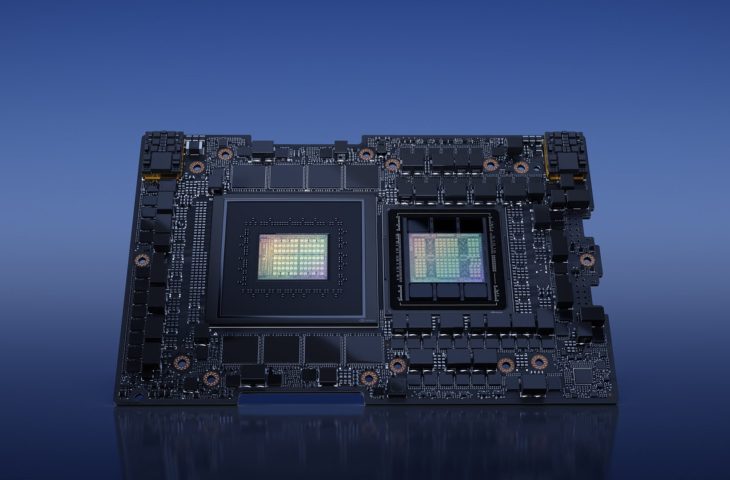

Le concept est maintenant devenu réalité. Nvidia confirme que la Grace Hopper est produite en masse. La puce combine le processeur Grace basé sur l’ARM avec l’architecture GPU Hopper qui prend également en charge le puissant accélérateur H100. En théorie, le résultat est un système sur puce (« System-on-a-Chip ») extrêmement puissant. Les caractéristiques de Grace Hopper :

- 72 cœurs de CPU Arm Neoverse V2

- 528 cœurs Tensor de GPU (Hopper)

- 132 multiprocesseurs de streaming GPU (Hopper)

- 900 GB/sec NVLink 4 CPU-GPU-interconnect

- Jusqu’à 96 Go de mémoire HBM3

- Bande passante de la mémoire GPU de 4TB/sec

- Jusqu’à 80 Go de mémoire LPDDR5X ECC

- 512 GB/sec Bande passante de la mémoire du CPU

- TDP de 450 watts à 1 000 watts

Nvidia ajoute qu’elle compte sur le processus 4nm de TSMC pour la fabrication de la puce. Les caractéristiques ci-dessus s’appliquent à la configuration maximale actuelle, qui ne sort de la chaîne de production qu’en nombre limité. La plupart des puces devront se contenter d’une mémoire HBM3 de 80 Go.

La mémoire du processeur ne provient pas de modules DIMM classiques, mais se trouve sur la super-puce. La vitesse d’horloge est donc plus élevée et la consommation plus faible, mais la flexibilité est évidemment sacrifiée. Le TDP élevé est remarquable, mais il est difficile de le comparer au TDP d’un processeur ou d’un GPU classique. En effet, la super-puce, baptisée GH200 par Nvidia, couvre la quasi-totalité du système informatique.

Superordinateur

Le GH200 sera également disponible dans le courant de l’année. En attendant, Nvidia annonce déjà un nouveau système DGX. Le superordinateur DGX GH200 AI n’est pas une mince affaire, car il se compose de 24 racks. Il peut contenir 256 puces GH200. Nvidia prévoit une puissance de calcul FP8 d’environ un exaflops. Cet appareil est donc un supercalculateur complet, à tous points de vue. Notez qu’il ne s’agit pas d’un ordinateur exascale, car les systèmes HPC du Top 500 sont mesurés sur la base d’un test FP64.

Les superchips du supercalculateur DGX bénéficieront de 96 Go de mémoire HBM3 et seront les meilleurs à sortir de la chaîne de production de TSMC. Les GH200 utilisés dans d’autres serveurs seront généralement équipés de 80 Go de mémoire HBM3. Nvidia a décidé de supprimer un cluster HBM sur ces modèles, vraisemblablement pour augmenter le rendement. Le supercalculateur sera disponible à partir de la fin de cette année, mais on doute que notre pays comprenne beaucoup d’entreprises ou d’agences qui entrent dans le créneau des clients prévus. Les serveurs GH200 « classiques » seront construits par d’autres fabricants tels qu’Asus et Gigabyte.

Compétition

Avec sa super-puce Grace Hopper, Nvidia lance une nouvelle course au matériel. AMD prévoit de lancer prochainement une puce similaire, basée sur ses propres processeurs Zen 4 et sur l’architecture CDNA3-GPU. Cette super-puce sera baptisée AMD Instinct MI300. TSMC se réjouit de cette évolution, car le fabricant fabriquera également ces puces informatiques.

Quant à Intel, le fabricant a cru brièvement vouloir se joindre à la course avec un XPU Falcon Shores, mais il a depuis renoncé par avance à cette idée. Toutefois, si Nvidia et AMD ont raison, les super-puces deviendront des composants clés pour soutenir l’explosion de la formation et de l’inférence de l’IA.