La vitesse de la mémoire de la Nvidia GH200, la Grace Hopper Superchip, est renforcée et la plate-forme est élargie avec une capacité 3,5 fois plus élevée.

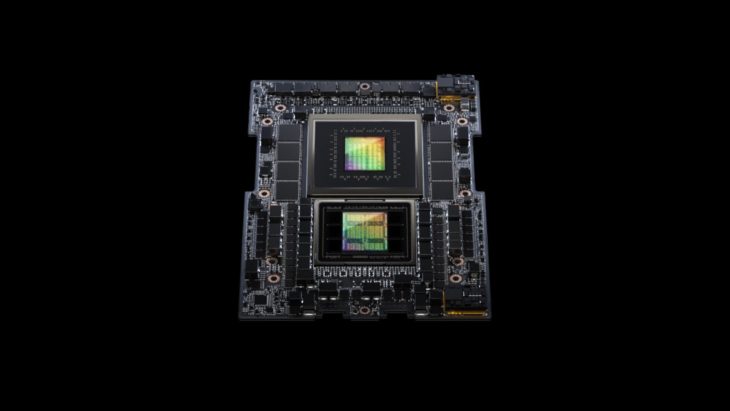

C’est une bonne année pour Nvidia avec la très puissante Grace Hopper Superchip. Elle associe une puce ARM à un puissant GPU, le H100. C’est le summum ultime pour les charges de travail d’IA générative et aussi une vraie mine d’or pour Nvidia, qui ne peut à peine répondre à la demande. Un seul GPU Nvidia H100 coûte déjà en moyenne 40 000 dollars aujourd’hui.

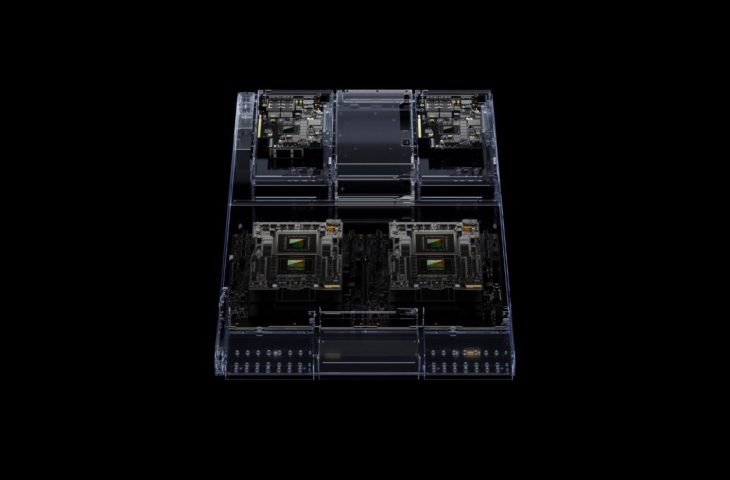

Le Nvidia NH200 n’est pas nouveau, mais la plate-forme sur laquelle le fabricant réunit deux puces de ce type l’est. Nvidia se concentre ainsi sur les charges de travail complexes d’IA générative telles que les LLM et les bases de données vectorielles. De nombreuses configurations sont disponibles. Le modèle le plus performant comprend 144 cœurs Arm Neoverse, 8 pétaflops de performances IA et une mémoire HBM3e fabuleuse de 282 Go.

HBM3e comme première option

En collaboration avec SK Hynix, Nvidia pourrait être le premier à travailler sur le HBM3e. Grâce en partie au processus plus petit de 10 nanomètres, cette nouvelle version est environ 50 % plus rapide que la HBM3 qui se trouve traditionnellement dans un GH200 de Nvidia. Cette vitesse plus élevée est importante pour les LLM et les réseaux neuronaux en général, car leur architecture peut l’utiliser au maximum de son potentiel.

Dans une configuration double sur la nouvelle plate-forme Grace Hopper Superchip GH200, Nvidia affirme que la capacité de mémoire est jusqu’à 3,5 fois plus élevée et offre trois fois plus de bande passante que la génération actuelle. Au total, la mémoire HBM3e offre une bande passante combinée de 10 To/s.

Cluster superérieur rapide

La nouvelle plate-forme est également le fondement d’un système de centre de données appelé Grace Hopper Compute Tray. Chaque système combine un seul GH200 avec les puces BlueField-3 et ConnectX-7 de Nvidia. Ces deux dernières puces sont conçues pour accélérer le trafic réseau vers et depuis le serveur. BlueField-3 peut également prendre en charge un nombre limité de tâches de calcul.

Au total, il est possible de relier jusqu’à 256 modules Grace Hopper Compute Tray dans un seul cluster. Selon Jensen Huang, PDG de Nvidia, un tel cluster peut fournir une performance d’IA de 1 exaflop.