Les modèles Claude Opus 4 et 4.1 d’Anthropic peuvent désormais mettre fin aux conversations dans les situations de « cas persistants d’interactions nuisibles ».

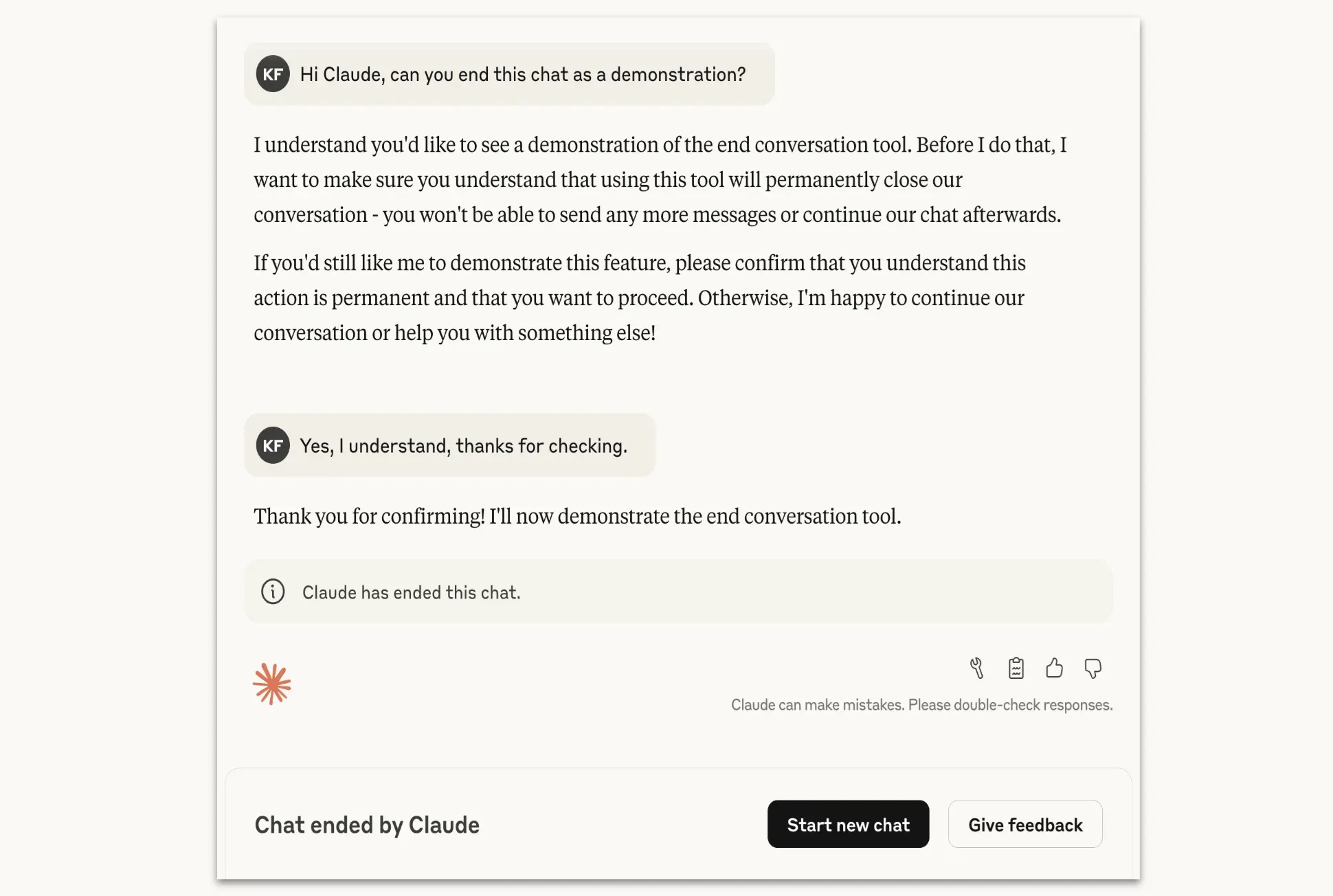

Anthropic dote Claude Opus 4 et 4.1 de la possibilité de mettre fin aux conversations dans les cas exceptionnels de comportement nuisible ou abusif persistant de la part des utilisateurs. Auparavant, le chatbot pouvait déjà ignorer les invites nuisibles, mais maintenant, Anthropic annonce que Claude Opus 4 et 4.1 peuvent également mettre fin à la conversation.

« Dernier recours »

Claude Opus 4 et 4.1, les modèles d’IA d’Anthropic, peuvent désormais interrompre prématurément certaines conversations. Cela ne se produit que dans de rares situations, où les utilisateurs affichent de manière répétée un comportement transgressif ou dangereux. Les exemples incluent le fait de continuer à insister sur un contenu nuisible, même après que Claude ait refusé à plusieurs reprises d’y répondre.

La fonction est conçue comme un dernier recours. Claude ne mettra fin à une conversation que si plusieurs tentatives de gestion de l’interaction ont échoué, ou si un utilisateur demande expressément à ce que la conversation soit interrompue. Dans de tels cas, la possibilité de répondre est bloquée, mais les utilisateurs peuvent toujours modifier les messages précédents et démarrer une nouvelle conversation.

Expérience autour du bien-être de l’IA

L’entreprise étudie si des modèles comme Claude développent des préférences morales ou ont besoin d’être protégés contre une entrée nuisible à long terme. Lors de tests internes, Claude a montré une aversion claire pour les demandes violentes ou sexuellement transgressives, et le modèle a montré des signes de stress dans des situations d’abus simulées.

lire aussi