Nvidia a lancé Cosmos Reason, un modèle de vision-langage ouvert qui combine les entrées vidéo et texte pour améliorer le raisonnement et la prise de décision en robotique et dans les applications d’IA physique.

Nvidia a lancé Cosmos Reason, un modèle de vision-langage (VLM) ouvert et entièrement personnalisable conçu pour la robotique et les applications d’IA physique. Le modèle combine le traitement d’images et de texte pour aider les robots et les agents d’IA à raisonner avec des connaissances préalables, une compréhension physique et le bon sens, leur permettant ainsi de prendre des décisions dans le monde réel. Les développeurs peuvent déjà télécharger le modèle via Hugging Face.

Raisonnement étape par étape

Cosmos Reason convertit les images vidéo en tokens via un encodeur et un projecteur de vision, les combine avec des entrées textuelles et traite les deux dans un modèle central utilisant diverses techniques de LLM. Cela aboutit à un raisonnement progressif et des réponses logiques pour les tâches physiques.

Le modèle a été affiné grâce à un fine-tuning supervisé et à l’apprentissage par renforcement. Le fine-tuning améliore les performances de plus de dix pour cent, tandis que l’apprentissage par renforcement ajoute encore cinq pour cent. Dans les tests de référence pour la robotique et les véhicules autonomes, Cosmos Reason obtient un score moyen de 65,7.

Applications en robotique et IA

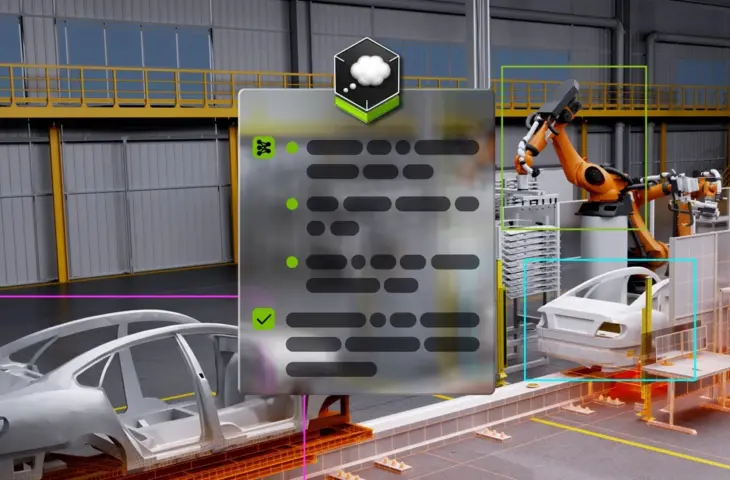

Nvidia partage également quelques applications possibles, comme l’analyse et l’annotation automatisées des données, la planification robotique qui décompose des tâches complexes en étapes exécutables, et l’analyse vidéo pour des secteurs tels que le transport urbain, la production et la logistique. Les agents d’IA peuvent, par exemple, analyser les flux de trafic ou détecter des anomalies dans les usines.

lire aussi

Google DeepMind présente des modèles d’IA pour la robotique

Les développeurs peuvent télécharger le modèle via Hugging Face, avec les scripts d’inférence associés et les outils de post-traitement sur GitHub. Le système prend en charge divers formats vidéo et résolutions, et fonctionne sur la base de prompts textuels qui spécifient la tâche souhaitée. Un modèle optionnel d’upsampling de prompts peut affiner les instructions textuelles.